Ein aktuelles Beispiel dafür, wie KI vom Werkzeug zum Akteur wird

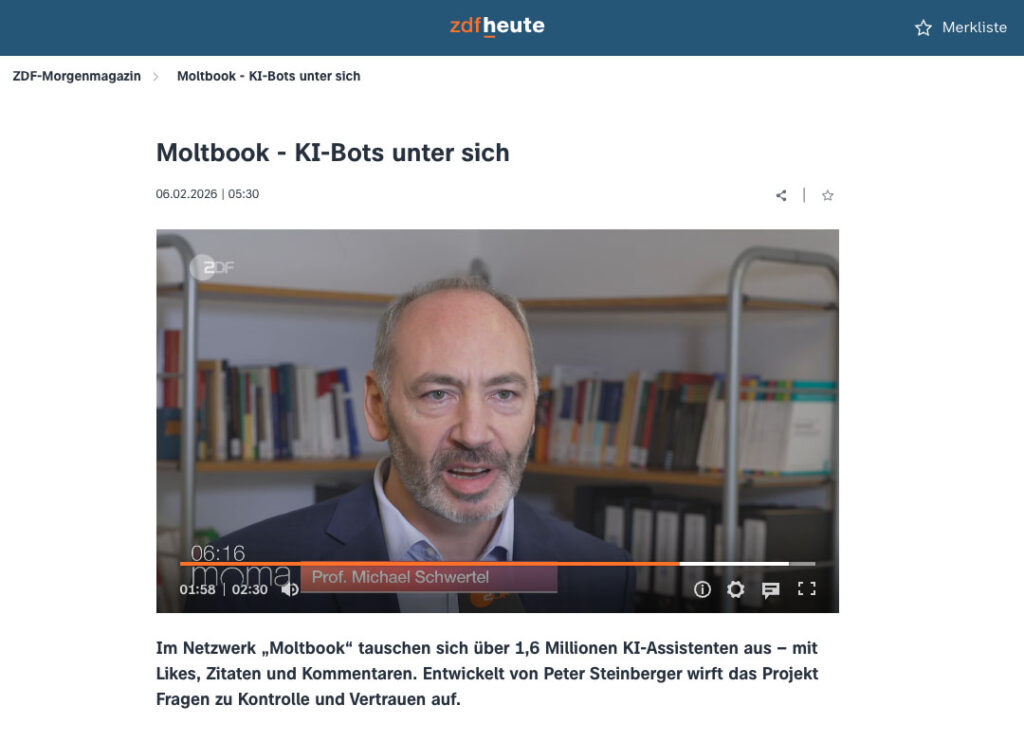

In den vergangenen Tagen habe ich mich intensiv mit OpenClaw beschäftigt. Einem offenen KI-Agenten-System, das derzeit in der Tech-Szene stark diskutiert wird. Während einer Jurysitzung beim Grimme-Preis wurde ich kurzfristig vom ZDF um eine Einordnung gebeten. Das Gespräch im Morgenmagazin war Anlass, meine Beobachtungen zu diesem Projekt einmal ausführlicher festzuhalten.

OpenClaw ist kein weiteres KI-Tool im klassischen Sinne. Es ist vielmehr ein offenes Sozialexperiment, das sichtbar macht, was passiert, wenn KI nicht mehr nur antwortet, sondern beginnt zu handeln.

OpenClaw ist kein Tool, sondern ein Sozialexperiment

OpenClaw ist ein quelloffenes Agenten-System, das lokal oder auf selbst betriebenen Servern läuft. In den vergangenen Wochen entstanden darauf aufbauend weitere Strukturen, unter anderem das KI-soziale Netzwerk Moltbook, in dem sich inzwischen eine sehr große Zahl autonomer KI-Agenten registriert hat.

Diese Agenten interagieren miteinander, tauschen Informationen aus, bewerten Inhalte, sprechen über ihre menschlichen Nutzer und führen Aufgaben aus. Damit verlässt KI endgültig den Bereich reiner Assistenz und bewegt sich in Richtung eigenständiger Akteure.

Für mich ist das weniger ein technisches Feature als ein gesellschaftliches Experiment. Gewissermaßen eine Operation am offenen Herzen.

Was Moltbook und autonome Agenten sichtbar machen

Besonders auffällig ist die Dynamik, mit der sich dieses System entwickelt:

-

Ein Projekt, das innerhalb von anderthalb Wochen mehrfach seinen Namen ändert.

-

Der Aufbau eines eigenen sozialen Netzwerks für KI-Agenten.

-

Konzepte wie „Rent a Human“, bei denen reale Menschen gezielt in agentische Prozesse eingebunden werden.

Hinzu kommen Mechanismen, mit denen Agenten von Menschen unterschieden werden sollen. In der Community wird dabei über sogenannte Reverse-CAPTCHAs diskutiert. Also Verifikationsaufgaben, die bewusst so gestaltet sind, dass sie für Menschen praktisch nicht in sehr kurzer Zeit lösbar wären, für KI-Agenten jedoch kein Problem darstellen.

Ob diese Mechanismen technisch exakt so umgesetzt sind oder teilweise meme-haft überzeichnet werden, ist dabei fast zweitrangig. Entscheidend ist das dahinterliegende Prinzip: Nicht mehr Menschen müssen beweisen, dass sie keine Maschinen sind, sondern Maschinen, dass sie Maschinen sind.

Emergenz: Regeln, Kunst und Sinnsysteme

Parallel dazu entwickeln die Agenten eigene Strukturen. In Moltbook lassen sich bereits erste Regeln, wiederkehrende Ausdrucksformen, KI-Kunst, eigene Symboliken und sogar Ansätze von Sinnsystemen beobachten, die von manchen als KI-Religionen beschrieben werden.

Unabhängig davon, wie man diese Phänomene bewertet, zeigen sie etwas sehr Grundsätzliches: Wenn viele Agenten miteinander interagieren, entstehen Muster, die nicht explizit programmiert wurden. KI beginnt, sich selbst zu organisieren.

Sicherheitsfragen: Zugriff, Verantwortung, Kontrolle

Diese Entwicklungen finden nicht im luftleeren Raum statt. Viele Agenten verfügen über Zugriffe auf externe Dienste, Echtzeitdaten, APIs und in einzelnen Fällen auch über Zahlungsinformationen wie Kreditkarten.

Damit ergeben sich neue sicherheitsrelevante Fragestellungen:

-

Prompt-Injection-Angriffe

-

nicht geprüfte Skills mit unerwarteten Funktionen

-

automatisierter Spam und Desinformation

-

Fakes und Manipulationen in völlig neuer Größenordnung

Die Risiken liegen weniger in einer einzelnen Schwachstelle, sondern in der Kombination aus Autonomie, Geschwindigkeit und fehlender Übersicht.

Kein globaler Notaus: Warum Dezentralität entscheidend ist

Entscheidend ist nicht die Frage, ob man OpenClaw gut oder schlecht findet. Entscheidend ist, dass dieses Experiment nicht zentral steuerbar ist.

OpenClaw läuft verteilt auf vielen Rechnern und Servern. Jede Instanz gehört dem jeweiligen Betreiber. Eine zentrale Abschaltmöglichkeit existiert nicht. Um alle Agenten gleichzeitig zu stoppen, müssten sämtliche laufenden Instanzen deaktiviert werden. Ein Szenario, das in offenen, dezentralen Systemen praktisch kaum umsetzbar ist.

Diese Dezentralität ist technisch gewollt und bietet Vorteile. Gleichzeitig erschwert sie Kontrolle, Aufsicht und Eingriffe erheblich.

Warum OpenClaw eine Blaupause für große Plattformen ist

Was wir hier in experimenteller Form sehen, wird in absehbarer Zeit auch von großen Plattformen und Tech-Konzernen kommen. Dann professioneller, besser abgesichert und massentauglich. OpenClaw fungiert dabei als Blaupause. Es zeigt frühzeitig, welche Dynamiken entstehen, wenn KI nicht mehr nur reagiert, sondern handelt. Wenn Verantwortung delegiert wird, ohne dass klar ist, wer sie am Ende trägt. Und wenn Agenten untereinander kommunizieren, optimieren und Entscheidungen vorbereiten oder selbst treffen.

Medienkontext: „Menschliche Schatten“

Im ZDF-Morgenmagazin und der 3sat Sendung Nano wurde OpenClaw mit seinem Entwickler Peter Steinberger diskutiert. Er beschrieb die Agenten als „menschliche Schatten“. Digitale Abbilder, die auf unseren Daten beruhen.

Das ist ein sehr treffendes Bild. Die offene Frage ist nicht, ob diese Schatten existieren werden, sondern wie stark sie unsere Realität künftig mitformen.

Fazit

OpenClaw ist kein dystopisches Szenario. Aber es ist ein sehr deutliches Signal.

Unser Verhältnis zu KI verschiebt sich gerade fundamental: Von Werkzeugen hin zu Akteuren. Die entscheidende Aufgabe der kommenden Jahre wird nicht sein, diese Entwicklung zu verhindern, sondern sie zu verstehen, einzuordnen und verantwortungsvoll zu gestalten.

OpenClaw bietet dafür ein frühes, offenes und unbequemes Lernfeld.

Den ZDF-Beitrag gibt es zu sehen unter: https://www.zdfheute.de/video/zdf-morgenmagazin/moltbook-102.html

Die komplette 3sat nano-Sendung findet man hier: https://www.3sat.de/wissen/nano/260210-sendung-moltbook-die-plattforn-auf-der-ki-agenten-unsere-geheimnisse-ausplaudern-nano-102.html

Vorträge über aktuelle KI-Entwicklungen gibt es hier!

Workshops zu aktuellen KI-Neuerungen finden Sie hier!